放送字幕最前線!【Connected Media TOKYO 2019レポート】

編集部

2019年6月12日〜14日の3日間、千葉県・幕張メッセにて、マルチスクリーン・クラウド・ビックデータなどデジタルメディア分野における技術を集めたカンファレンス『Connected Media TOKYO 2019』が開催され、全期間で15万人を超える来場者を記録した。今回はこの中から、6月13日に開催された専門セミナー『放送字幕最前線!』をレポートする。パネリストとして、NHK放送技術研究所の佐藤庄衛氏と株式会社テレビ朝日 技術局 技術戦略部の藤井祐介氏、株式会社TBSテレビ 技術局送出部兼技術推進部の木村浩也氏が登壇。モデレーターを関西テレビ放送株式会社 社長室 経営戦略部 兼 放送技術局 技術推進部の坂梨裕基氏が務め、放送字幕の自動作成に向けたリアルな奮闘の模様を語った。

■ワンマン送出に対応した『TBS NEWS』の字幕送出システム

セッション冒頭では、登壇者一同が自局で取り組む「自動字幕作成システム」の事例を紹介。TBSテレビの木村氏のプレゼンテーションからスタートした。

TBSテレビでは、同局が運営するニュース専門チャンネル『TBS NEWS』の放送現場において、字幕を放送音声とのディレイなしで24時間付与するシステムを独自開発。第45回放送文化基金賞を受賞した。

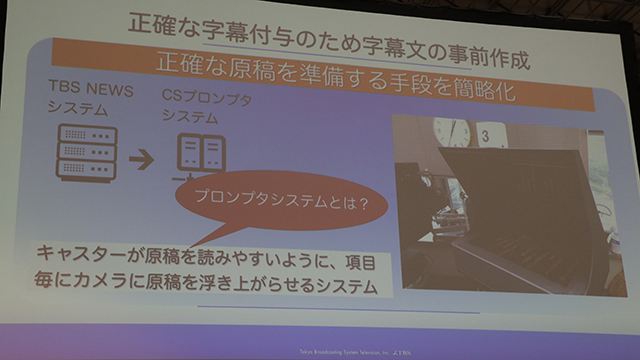

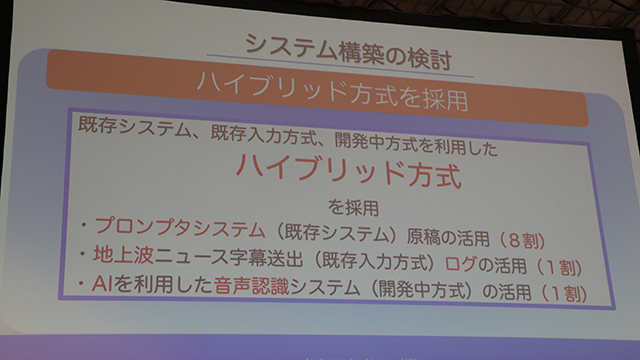

字幕の生成にあたり、キャスター向けに映し出されるモニター(プロンプターシステム)用に作成した原稿と、字幕オペレーターによって速記入力された地上波でのニュース字幕送出ログと、AIによる放送音声の音声認識データを利用した「ハイブリッド方式」を採用。あらかじめ作成されたニュース原稿を主に活用することで字幕用原稿を独自作成する過程を省いた。

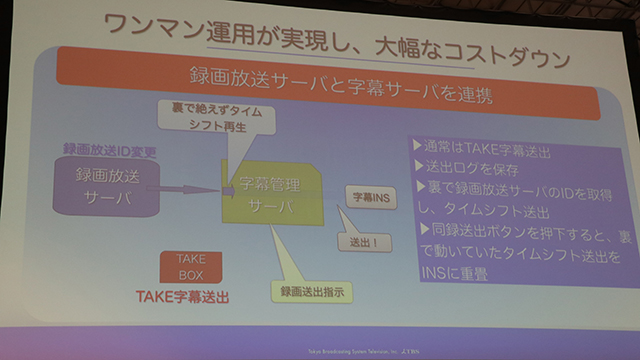

放送への送出におけるコストを削減するため、システムはワンマン操作を基調とした設計に。簡略な操作のWEBベースのインターフェースを持ち、ワンクリック操作で自動的に字幕原稿を準備。放送時はTAKE(送出)ボタンを手動操作することで、学生アルバイトでも簡単に送出作業が行えるようにした。『TBS NEWS』では生放送のほか、夜間を中心に生放送の映像を利用した録画放送を行っているが、これらの時間帯に自動字幕システムを使用した字幕送出を活用し、24時間放送に対応した字幕付与を実現しているという。

■AbemaTVで稼働する自動リアルタイム字幕システム『AIポン』

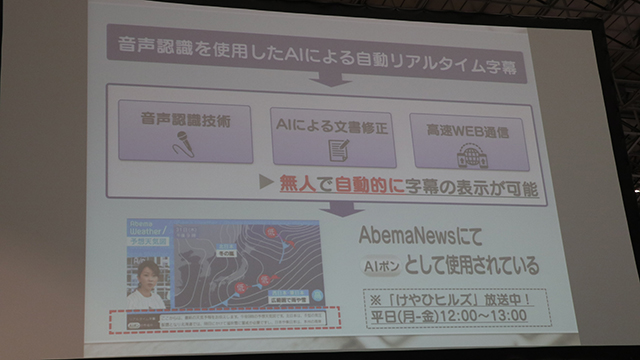

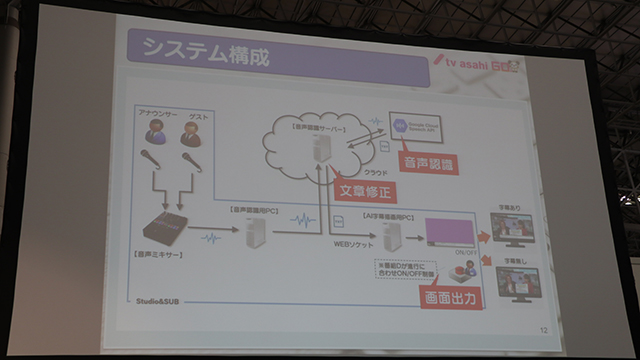

続いて、テレビ朝日の藤井氏がプレゼンテーション。音声認識技術を用いたAIによる自動リアルタイム字幕付与システム「AIポン」を紹介した。

「AIポン」では、Googleの音声認識プラットフォーム「Google Speech API」を使用し、放送音声を自動でテキストに変換。放送とほぼ同時にリアルタイムな字幕表示を実現している。生成されたテキストは同時にフィルター処理が行われ、文節ごとの句読点の付与や「あのー」「まぁ」といった発話の際に出る無意味な言葉の削除、あらかじめ指定した「放送禁止用語」の削除・置換が行われ、整形されたかたちで画面に表示される。放送とのタイムラグは約1秒程度と極めて高速な点が特長だ。

「AIポン」は、同局がサイバーエージェントと共同展開するインターネットテレビ局AbemaTV内のAbemaNewsチャンネルで実際に稼働。放送画面の下部に設けられた専用欄を通じて視聴者にリアルタイムな字幕が届けられている。

表示速度を追求するため、「AIポン」では言葉のブロック(文節)単位で細かくサーバーと通信を繰り返し、認識できた文字から描画。リアルタイムな字幕作成の様子を再現する演出も兼ねているという。今後は番組素材からの文字起こしへの活用や変換精度の向上、話者(誰が話しているか)の分離(表示)、地上波への展開などを見込んでいるという。

「たとえば通勤電車の中など、音声を出して視聴できない環境でも番組の内容を把握することができるような、新しい視聴スタイルの創出に技術的な面から貢献していきたい」と藤井氏は語った。

■「音声認識テキストをセカンドスクリーンに配信」NHKの実験事例

続いてNHKの佐藤氏が、同局における放送字幕生成への取り組みを紹介した。

現在NHKで用いられている生放送での字幕入力法は、複数人のオペレーターが専用仕様のキーボードを使って速記入力する「一般キーボードリレー方式」、放送での発話を担当者が聞き取って名称に発話し直し、これをオペレーターが速記入力する「リスピーク方式」、番組音声を直接音声認識して文字に変換する「ハイブリッド方式」、そして番組音声の認識結果から原稿を推定する方式の4種類。「一般キーボードリレー方式」は主に歌謡・情報・報道番組にて、「リスピーク方式」はスポーツ・情報番組にて、「ハイブリッド方式」は大都市圏の拠点局発のニュース番組、番組音声の認識結果から原稿を推定する方式は一部ローカル局のニュース番組にて用いられているという。

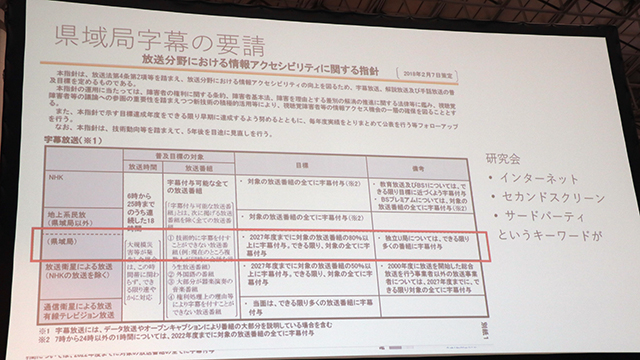

2018年2月に総務省が策定した『放送分野における情報アクセシビリティに関する指針』では、県域局において「2027年度までに対象の放送番組80%以上に字幕付与」という目標が提示された。

NHKでは県域放送を行なうローカル放送局を多数抱えているが、佐藤氏は「各局ごとに字幕オペレーターを配置したり、設備を整備したりすることは現実的ではない」と。そのため、解決策として「県域局の番組音声をクラウドで音声認識し、認識結果をそのままセカンドスクリーンに配信することで字幕放送の代用とする方式を提唱し、実証実験を行っている」という。

実験対象となっているのは、平日夕方にNHK福島・静岡・熊本の放送局が制作するローカルニュース枠。WEBベースの字幕表示システムを用いて、聴視覚にハンディキャップを持つ視聴者と一般視聴者において「どの程度正確な文字が出力できるか」「音声の誤認識がある字幕がどの程度許容されるか」「セカンドスクリーンでの視聴はどの程度許容されるか」といった反響を調査している。実験期間は2019年2月初頭から8月末までの予定で、「字幕に対して一定の誤りが許容されると判断できればサービス化を検討する」という。

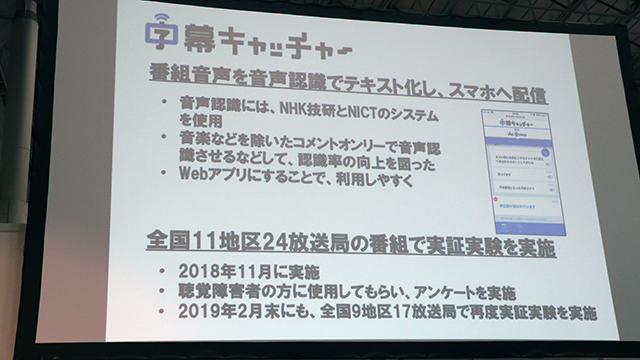

■クラウド利用で放送字幕をリアルタイム翻訳。関西テレビの「多言語字幕配信」

関西テレビの坂梨氏は、在阪民放局で構成する「マルチスクリーン放送協議会(マル協)」と、民放局と広告代理店、ITメーカー、家電メーカーらによる組織「マルチスクリーン型放送研究会(マル研)」メンバーの立場からも、マル協・マル研によるマルチスクリーン型のリアルタイム字幕実証実験「字幕キャッチャー」の事例を紹介した。

「字幕キャッチャー」は先出NHK同様番組音声を音声認識でテキスト化し、スマートフォンアプリに配信する仕組み。音声認識にはNHK放送技術研究所と国立研究開発法人情報通信研究機構(NICT)の開発した技術を使用し、認識用の音声には楽曲などを除いた「コメントオンリー」の音源を使用することで認識率の向上を図っているという。

2018年11月、同システムを用いた実証実験を全国11地区24放送局の番組で実施。2019年2月にも全国9地区17放送局を対象に再実験が行われた。

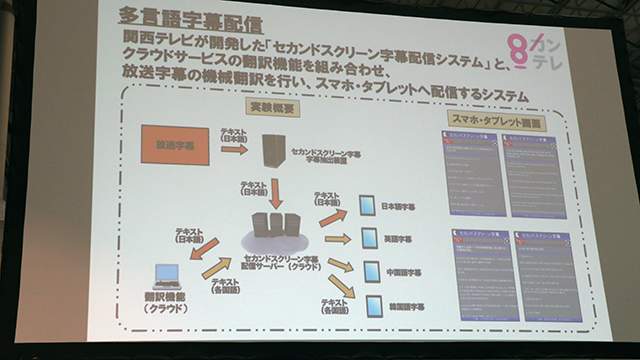

続いて坂梨氏は、関西テレビ単体の取り組みとして「多言語字幕配信」の事例を紹介。同社が開発した「セカンドスクリーン字幕配信システム」とクラウドサービスの翻訳機能を組み合わせ、放送字幕の機械翻訳を実施。スマートフォン・タブレット端末に向け、多言語に翻訳されたリアルタイム字幕データを配信するシステムを構築しているという。

■「字幕の誤り」をどこまで許容するか

続いてセッションは、登壇者らによるパネルディスカッションへ。1つ目のテーマとして「『字幕の誤り』をどこまで許容するか」という議題が掲げられた。

TBSテレビの木村氏は「(TBS NEWSの字幕生成システムでは)音声認識データをメインとして扱わない判断をした。報道なので一字一句間違えてはいけないと厳命されているが、被害者や加害者に関する情報や、その他にも特に及ぼす影響の大きい話題についてはさらに誤りが許されない。音声認識はサポート程度の利用にとどめている」と、字幕の誤りについては基本的に許されないという厳し目のスタンスを見せた。

テレビ朝日の藤井氏は「(インターネット配信であるAbemaTVと地上波では)メディアの差が大きい。地上波で同様のことが出来たかというと難しかったと思う」とし、「間違ったら誰が責任を取るのか、という問題は局によって違うだろう。そういった意味で、私たちとしてはAbemaTVの協力の元、試験的にでも実運用で行えたことは大きかった。」と述べた。

NHKの佐藤氏は「間違ってはいけないのは確か」としながらも、「音声認識を研究しているものとしては、どんどん改善はするものの100%には達しない」と実情を吐露。「現在の(人力による)正しい(内容の)字幕に、音声認識(によって生成された不確実な字幕)が交じると(視聴者は)混乱すると思う」と所見を述べた。

これらパネリストの声に対し、モデレーターの関西テレビ・坂梨氏は「もう少し字幕の誤認識に対する許容のハードルがゆるくなれば、(字幕そのものを)出せる場所は増えるのではないか」と述べた。

■『第二字幕』を使用しての音声認識字幕配信の是非

つづいてディスカッションのテーマは「地上波デジタルの第二字幕を用いて、音声認識によるリアルタイム字幕を流せばよいのではないか」というアイデアを掲げ、これに関する是非をパネリストたちに問う形となった。

地上波デジタルテレビにおける字幕表示用のデータ領域には、メインである第一領域に加え、英訳などを載せたりできる、いわば「副音声」的に使用できる第二字幕の領域がある。「第一領域」には従前どおり正規化された字幕を表示し、「第二領域」に音声認識を用いたリアルタイム字幕を表示することで、視聴者側の選択肢を増やしつつ、実験が行えるのではないかという考えだ。

TBSテレビの木村氏は「(実験できる)フィールドがあるのはすばらしい」と賛成の意見。「『TBS NEWS』においても、音声認識ベースの自動字幕生成システム研究が進んでいる。この仕組を使えば、実は100%どの番組にも字幕を付けることができる」と話し、「字幕付与率達成の材料になれば良い」と希望をのぞかせた。

テレビ朝日の藤井氏も「(『AIポン』によるリアルタイム字幕付与は)やろうと思えば地上波でもできる」とし、「(正規の)字幕として認めてもらえるのであれば、(『AIポン』のシステムを用いて)他局と連携して進めることもできると思う」と語った。

NHKの加藤氏は、先出のセカンドスクリーン実験を例に出しながら「ネット配信経由の字幕送出にはタイムラグがある」とし、「表示の速さという点では放送規格の字幕が有利」と返答。そのうえで「表示が遅れすぎる場合は、話者が誰かを区別する情報を付与するなどの対策を行なう必要がある。表示の遅れそのものがなければ(これらのフォローも必要なく)視聴者の不満も少ないのでは」と、第二字幕の利用に対しては現実的との見解を示した。

モデレーターの関西テレビ・坂梨氏は「技術的には可能」としつつ、「この場では結論は出ない」とフォロー。「これをきっかけに、字幕のありかたについて考える機会としてもらえたら」と語り、セッションを締めくくった。

各社ともに字幕の自動生成は「技術的に可能」という水準に達している一方、放送に求められる正確性の担保という面で展開には慎重な様子が伝わってきた。より充実した視聴体験の選択肢を広げるという観点からも、視聴者サイドからの働きかけがこれらの現状を後押しすることにつながるのかも知れない。